百度后台:Robots.txt 设置失效是怎么回事?

SEO是一个细节工作,看数据是一项必修课!

这两天有很多SEO运营,私信我们,发现自己网站屏蔽的一些禁止搜索引擎抓取的页面,大幅度的被百度收录。

很多SEO运营小伙伴,觉得我明明在百度搜索资源平台,设置好robots.txt权益,怎么还大量被收录,难道我是配置错误吗?

那么,百度后台:Robots.txt 设置失效,还是权益调整?

根据蝙蝠侠IT,SEO实战经验,将通过如下内容阐述:

1、更新robots.txt

去查看robots.txt是否正确设置,特别是百度后台和自己的网站根目录是否一致,而不是因为缓存没更新,导致差异化。

一个最简单的办法就是去:百度搜索资源平台后台去更新一下robots.txt,具体的链接可以参考:https://ziyuan.baidu.com/robots/

我们可以去更新一下,看看是否和自己根目录下面配置的文件一样。如果一样的话,我们进行下面的操作。

2、检测robots.txt

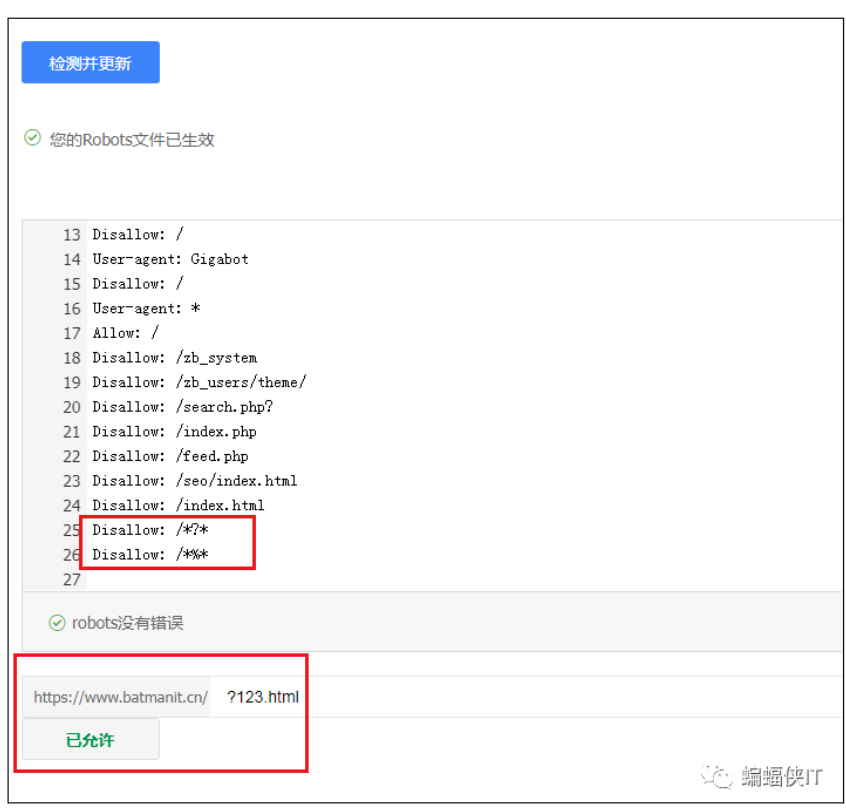

如上图,更新后的Robots.txt文件,我们可以清晰的在后台看到我们实际上屏蔽了动态参数“?”。

但在实际抓取测试的时候:?123.html 仍然是可以被抓取的,起初我们以为百度在设置robots.txt权益的时候,调整了问号的抓取规则。

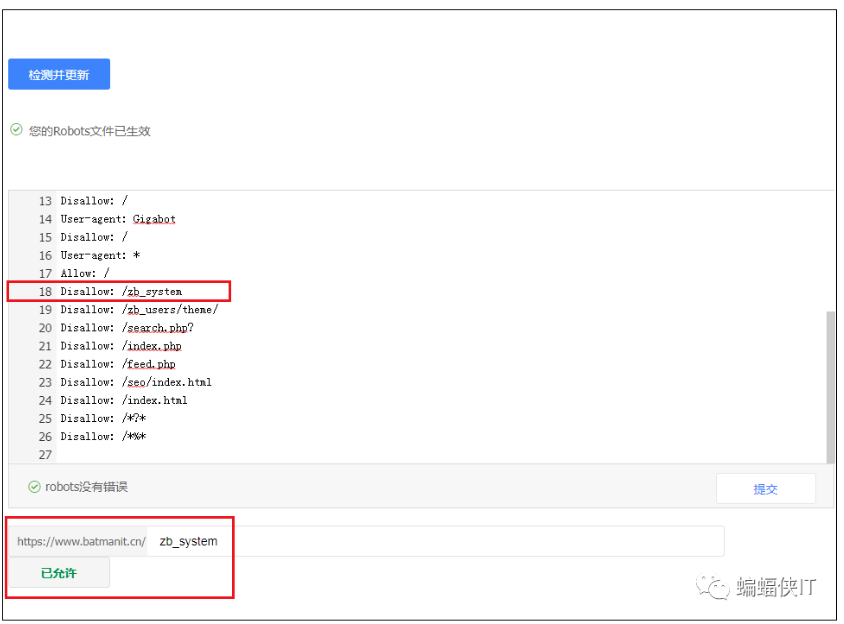

后来我们在实测了其他路径地址,如下图:

你会发现同样会被抓取,于是我们猜测,可能百度搜索资源平台,关于robots.txt这个文件的配置权益出现问题,或者调整了这个文件的权益。

目前,感觉是失效的状态。

3、引发问题思考

① 广告跟踪代码

很多开竞价的小伙伴,在开启SEM的时候,都是直接对标自己的官网,很多落地页后面都会有追踪参数,传递的数值。

比如:?f=baidu&k=1150

理论上,当我们在robots.txt屏蔽动态参数问号的时候,原则上之前是不会被百度收录的,但最近这个问题,很多小伙伴反馈,说出现重复性收录的问题。

对于竞价这没有任何问题,对于SEO来讲,他造成大量重复性页面。

② 动态URL调整伪静态

这是一个隐蔽性问题,很多网站早期是动态URL,而后期改成了伪静态,在做robots.txt策略的时候,原则上是需要做301重定向到伪静态页面的。

同时,有部分在做完成权重传递之后,是进行了动态链接屏蔽,启用了在robots.txt中,屏蔽问号的策略。

而这次robots.txt规则权益出现问题,往往也会导致这样的网站大量出现收录旧网址的情况。需要我们注意。

目前这样的网站比较尴尬,没有特别好的解决方案,特别是做了301重定向的站点。已经完美的配置了相关策略。

4、临时解决方案

如果你的网站站内页面,之前存在动态链接,并且在robots.txt屏蔽了相关性参数,这次百度robots.txt规则出现问题。

我们想要把损失降到到最小化,尽量还是在站内,特定URL中,标注nofollow标签吧。

只能做临时的解决方案。

关注蝙蝠侠IT:带你看最真实的百度SEO!